图片来源@pixabay

当前,万卡或超万卡集群已经成为各大科技巨头竞相部署的重要战略资源。

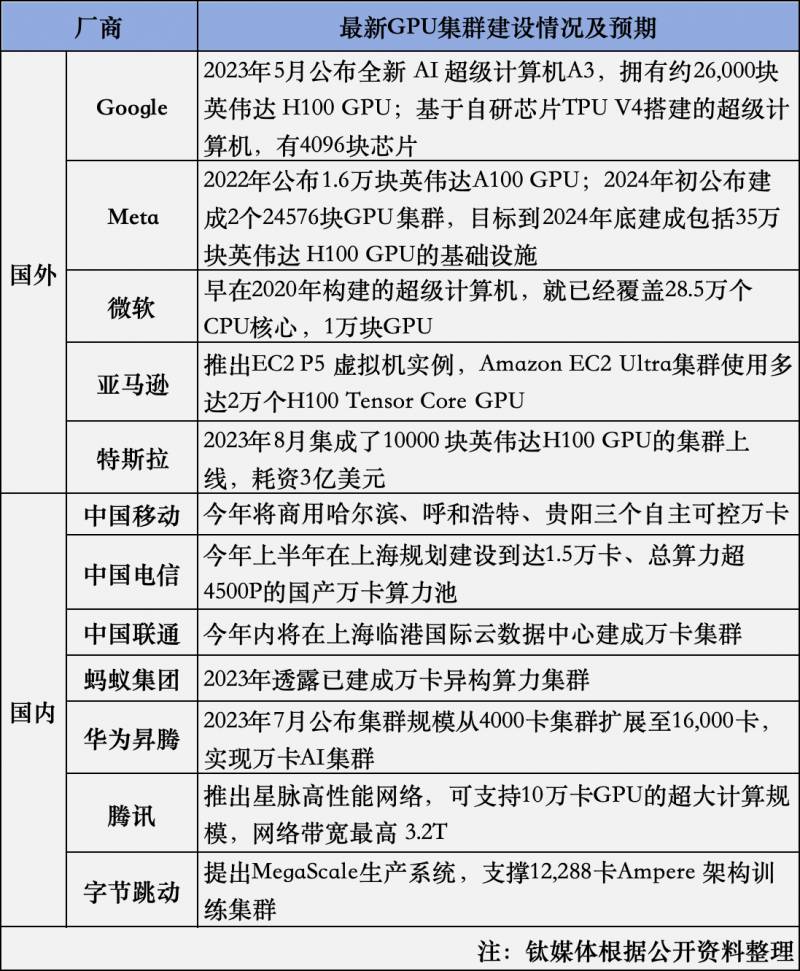

钛媒体此前对万卡集群有过解释,其核心就是在于将数万块GPU计算单元组合构建的高性能计算资源。而GPU作为推动AI训练和推理的关键力量,谁手里握有最多的GPU卡,也被视作AI的头号玩家。根据CB 的数据,英伟达占据了机器学习GPU市场约95%的份额,超过有4万家企业采购了英伟达GPU,像Meta、微软、亚马逊、谷歌总计贡献了其40%的收入。以Meta为例,2022年公布推出拥有1.6万块英伟达A100的Al研究超级集群,2024年初公布建成2个24576块GPU集群,目标到2024年底建成包括35万块英伟达H100 GPU的基础设施。

事实上,不只是国际厂商,国内厂商也在此前大量采购GPU推进万卡集群建设。尤其在今年以来,三大运营商也相继公布了对超万卡集群的部署。例如,中国移动今年将商用哈尔滨、呼和浩特、贵阳三个自主可控万卡集群,总规模近6万张GPU卡;中国电信于今年上半年在上海规划建设到达15,000卡、总算力超4500P的国产万卡算力池,将是国内首个超大规模国产算力液冷集群;中国联通表示,在今年内将在上海临港国际云数据中心,建成中国联通首个万卡集群。

在这其中已经出现几类关键角色,分别是通信运营商、头部互联网、AI头部厂商。值得关注的是,近些年新成立的基础大模型AI创企也在借助云大厂的投资租用或购买算力,类似于+微软的合作模式。钛媒体梳理了国内外头部厂商公布的数据,如图所示。

如今,模型参数量从千亿迈向万亿,大模型对底层算力的需求进一步升级。以GPT-4为例,其拥有16个专家模型共1.8万亿参数,一次训练需要在大约25000块英伟达A100上训练90到100天,对算力的消耗之大可见一斑。在这样的背景下,分散的小规模算力资源显得捉襟见肘,而万卡集群则能够提供足够的算力支持,满足大模型训练的需求。

另外,AI应用快速发展的时代,带来了与过去传统通用计算完全不同的挑战。单纯看以CPU为中心无法满足当下需求,以GPU、TPU等AI专用芯片组合的多元算力体系正被业界反复提及和验证。

服务器厂商聚焦互联

对于从事基础设施服务企业而言,自然有其解法。例如现阶段,AI需求市场对数据中心的建设要求,正影响服务器企业的判断和打法。围绕客户对AI场景展开,以政企、运营商以及头部互联网行业为主,并逐步拓展到更多行业领域。事实上,这种商业动因也促使服务器企业与上游更多的硬件伙伴展开密切配合。

其中一项核心要素是聚焦面向芯片互联技术。因为能够实现单个服务器内部芯片高速直通,是大规模算力集群高效协同的基础。

新华三集团高级副总裁、云与计算存储产品线总裁徐润安与钛媒体App交流谈到,从服务器整机角度来考虑,也需要跟上市场的发展。新华三希望做更加开放的平台,做上游GPU厂商合作伙伴的最佳选择,利用自身网络优势,对网络通信的理解,帮助更多GPU厂商,将算力互联互通实现得更好。

在他看来,过去,大家的目标可能是做更强算力的单颗芯片,现在会从另一个角度努力,怎样将芯片做成更大集群,同时使得集群的通信效果更高,集群的处理能力更强。

徐润安注意到,不同地域间的集群互联,最大挑战在于地域之间的延迟问题。评估后认为,超过上千公里延迟,在大规模训练中其实对大模型训练产生急剧下降,按照当前的广域网技术是无法解决的。

为此新华三提供的科学计算算力调度平台傲飞3.0,实现了跨集群统一管理,将训练任务进行切分,将合适的子任务放在合适的近端或远端模块集群实现。但是单一模型、单一子任务是很难实现这种操作的。

以新华三目前跟某高校的联合项目算网大脑为例,为解决各地算力资源调度问题,该算网大脑对整个计算资源进行统一池化管理,并且可视化算力信息、调度任务数等。在调度任务分配中,按亲和性原则,就近资源任务安排在既有空闲,和改任务调度有密切关联的集群部署,从而实现资源效率利用的最大化。同时利用确定性的网络技术,确保时延在一定范围内,既能够解决任务调度资源在各个中心的分配问题,也能解决整个集群协同的作用。

建设万卡集群的中企路径

考虑到万卡集群建设难度,不少国内企业正拉通服务器、芯片等基础设施服务提供商共同解决这一棘手难题。

在技术层面,首先需要实现大规模的高效率训练。由于模型训练需要分布到多个GPU上,并且GPU之间需要进行大量通信以推动进展,因此如何实现高效的模型分布式训练和通信是万卡集群面临的重要挑战之一。其次,还需要在大规模上实现训练的高稳定性。由于构建AI训练集群需要设计非常复杂的网络结构,但问题是,一旦集群规模扩大,带宽带来的系统可靠性就会急剧下降,这往往会导致训练过程中断,训练成本显着增加。因此,如何确保整个训练过程的高效稳定是万卡集群需要解决的另一个关键问题。

除此之外,国内企业还受上游英伟达A100 GPU芯片供货紧张的影响。尽管国产AI芯片在这两年取得长足进步,但在整体性能和生态构建方面仍存在一定差距。现阶段企业仍主要依赖英伟达GPU及配套设备实现,中国企业对于万卡集群的建设仍处于起步阶段。

因而,怎样构建一个基于国产生态体系、技术领先的万卡集群,在极致算力使用效率、海量数据处理、超大规模互联、高能耗高密度机房设计等方面存在诸多挑战。

结合《面向超万卡集群的新型智算技术白皮书》提出的超万卡集群核心设计原则,能够发现中国企业需要在计算、存储、网络、平台及机房配套等领域做出努力。

例如,白皮书针对上述提及的芯片互联问题也进行了详细阐释,提出基于互联打造单节点算力峰值,以及基于互联将单集群规模推高至万卡以上,两者叠加从而构建超万卡集群的大算力底座。

其实这段解释也将Scale-up和Scale-out两种不同的堆卡方式进行了区分。

据钛媒体App了解,目前英伟达更倡导,其构建的提供了一种高效可扩展的芯片间通信协议,允许所有GPU同时全速实时通信。企官方产品从NVL36和NVL72升级到,即从原先的36个或72个GPU,一下子扩展至576个GPU。这实际上进一步优化了互联的难题,针对的就是当前客户构建万卡集群的问题。如亚马逊、谷歌、微软和甲骨文都已经计划在其云服务产品中使用NVL72设计的集群。

那么回到国内生态,面向大模型训推场景带来的万卡集群算力需求,如实现单个服务器内部芯片高速直通,以及大规模算力集群高效协同?

新华三集团智慧计算产品线首席产品经理郑会平补充,异构融合将是未来大的发展方向,这意味着将存在如何快速调度异构资源的挑战。同时,管理万卡集群资源还需要在业务层面实现拉通。

结合白皮书也能够梳理出针对GPU卡间通信的解决思路:一是推进超越单机8卡的超节点形态服务器,二是引入面向的芯片,以优化GPU南向的互联效率和规模;三是优化GPU卡间互联协议以实现通信效率跃升。国内智算产业正以自身的优势背景走出不一样的路。(本文首发于钛媒体APP, 作者|杨丽,编辑 | 盖虹达)