(报告出品方/作者:国海证券,陈梦竹、尹芮、卢瑞琪)

一 、PC/手机发展史及AI PC/手机必要性的探讨

AI PC/手机作为端侧相较于云端能够解决数据安全、延迟等问题

AI PC/手机作为端侧大模型解决方案,能够帮助解决数据安全及隐私泄露等问题。对个人用户而言,可通过访问本地数据形成其数字孪生,大模型成为用户的个性化助理;对企业用户而言,可通过公司内网访问企业数据库以实现智能化协同办公。云端通用模型不具备服务某一领域的能力,需要接入数据后才具有专业能力,这意味着企业为获得行业模型,须将关键性资产——数据上传至云端,而一旦训练完成的模型被全行业共享,则意味着一定程度上企业竞争壁垒的消弭,由此催生出各企业在数据墙内训练专用模型的需求,AI PC/手机应运而生。 绝大多数应用场景下用户对推理的时效性要求较高,在云端进行推理再将结果传回端和边缘因物理距离而不可避免存在延迟,AI PC/手机直接面向终端用户,因此能很大程度上缓解这一问题,为用户带来更好的使用体验。

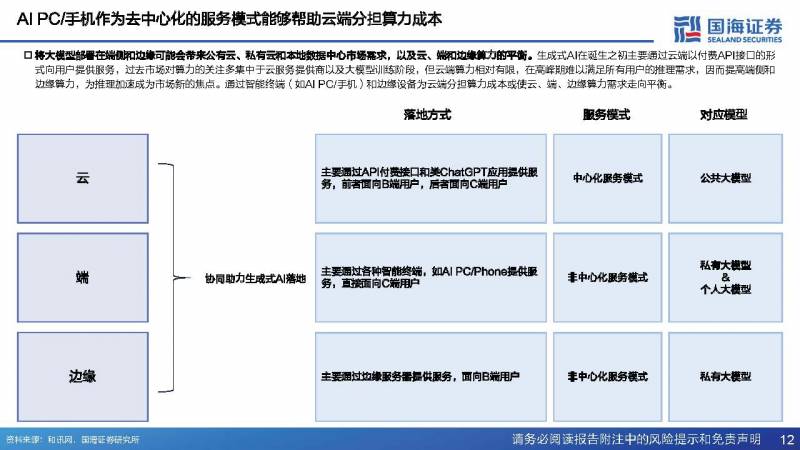

AI PC/手机作为去中心化的服务模式能够帮助云端分担算力成本

将大模型部署在端侧和边缘可能会带来公有云、私有云和本地数据中心市场需求,以及云、端和边缘算力的平衡。生成式AI在诞生之初主要通过云端以付费API接口的形式向用户提供服务,过去市场对算力的关注多集中于云服务提供商以及大模型训练阶段,但云端算力相对有限,在高峰期难以满足所有用户的推理需求,因而提高端侧和边缘算力,为推理加速成为市场新的焦点。通过智能终端(如AI PC/手机)和边缘设备为云端分担算力成本或使云、端、边缘算力需求走向平衡。

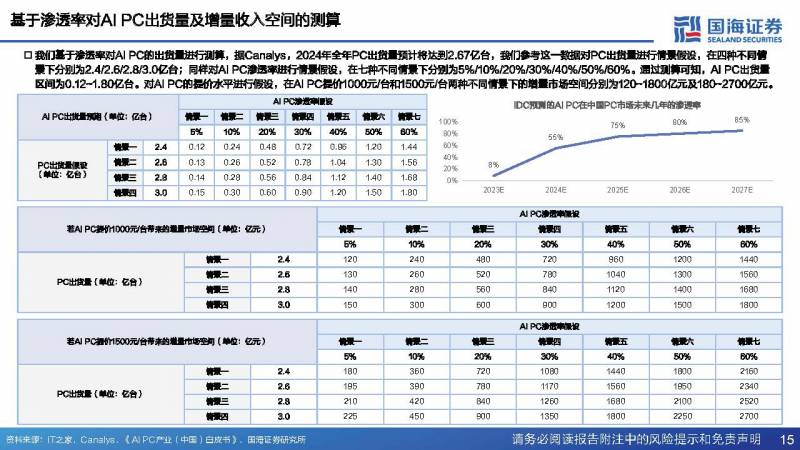

基于渗透率对AI PC出货量及增量收入空间的测算

我们基于渗透率对AI PC的出货量进行测算,据Canalys,2024年全年PC出货量预计将达到2.67亿台,我们参考这一数据对PC出货量进行情景假设,在四种不同情景下分别为2.4/2.6/2.8/3.0亿台;同样对AI PC渗透率进行情景假设,在七种不同情景下分别为5%/10%/20%/30%/40%/50%/60%。通过测算可知,AI PC出货量区间为0.12~1.80亿台。对AI PC的提价水平进行假设,在AI PC提价1000元/台和1500元/台两种不同情景下的增量市场空间分别为120~1800亿元及180~2700亿元。

二、从硬件角度看AI PC/手机潜在的投资机会

GPU发展史:诞生于专用性需求,作为辅助处理器执行并行计算任务

像处理催生出专用处理器需求,GPU的设计初衷正是为了应对批量同类任务的高并行执行,随着工艺的发展,GPU开始不断在个人PC以及移动设备上普及,甚至于随着其性能呈指数级增长,独显势头渐起。

NPU:诞生于神经网络计算的需求,相较于GPU同时兼顾专用性和能耗比

NPU( Unit),即神经网络处理单元,可在电路层模拟人类神经元和突触,并用深度学习指令集直接处理大规模的神经元和突触,一条指令完成一组神经元的处理。相较于CPU和GPU的冯诺依曼结构,NPU通过突触权重实现存储和计算一体化,从而提高运行效率。NPU是ASIC芯片的一种,目前主要应用于深度学习和机器学习等人工智能任务。

骁龙8 Gen3让手机运行大模型提速,骁龙 X Elite助力高通切入AI PC赛道

高通在2023骁龙技术峰会上发布用于AI手机的骁龙8 Gen3和用于AI PC的骁龙 X Elite,率先成为同时抢占生成式AI应用落地的两个端侧赛道的芯片厂商。就手机端而言,搭载了骁龙8 Gen3的手机运行 模型,只用0.6秒即在本地生成了一张图像,其相较于骁龙8 Gen2的15秒很大程度上优化了移动终端生成式AI的推理速度;就PC端而言,高通开创性地推出骁龙 X Elite平台,该处理器不仅拓展了生成式AI应用的广度,也是高通强势切入PC市场的重要举措。

PC搭载NPU成为AI PC时代开启的重要标志,叠加系统迭代或将带来换机潮

NPU作为人工智能相关任务专用引擎成为PC的核心零部件之一为AIGC在端侧落地打开可能性,是AI时代PC产品的重要革新。NPU相较于GPU拥有更优的能耗比,这意味着随着NPU在PC上普及,其与GPU的分工或将更加明确。此先作为图像处理专用芯片的GPU亦常用于深度学习相关领域,对矩阵加乘的并行计算能力使GPU在NPU之前一直是AI模型训练和推理倚赖的重要硬件单元。随着成为LLM的主流架构,并将CV和NLP这两个研究分支统一起来,神经网络成为构建AI模型的基本单元,NPU作为张量处理器能够在更短的时间内完成大规模神经网络计算任务,因而其相较于GPU是更适合人工智能相关任务的加速引擎。NPU将作为端侧重要的基础设施之一为PC端搭载大模型提供前提条件,其普及标志着AI PC时代的来临。

为支持端侧运行高规格大模型,AI PC的散热模组可能会迎来重构

散热能力是高算力芯片的一个主要瓶颈,随着搭载在AI PC和AI手机上的模型规格不断提升,NPU性能释放可能会更加激进,为配合硬件升级,相较于传统PC/手机, AI PC/手机可能会给出全新的散热解决方案。从数据中心来看,关键痛点是耗电和散热,在芯片的有限体积内,如何将高集成、高能量密度产生的热值和热效应准确计算并顺利排出,已经成为多源异构芯片3D封装中最具挑战性的问题。目前的消费电子终端,手机方面,不锈钢VC均热板开始逐渐取代铜VC均热板成为散热主力;PC的散热方案一般以组合的形式呈现,而散热模组( )从结构上看主要包括散热底座、热管、散热鳍片、散热风扇等物件。

大模型在端侧落地或使AI PC/手机厂商成为这一服务模式下的流量入口

大模型在端侧落地的主要受益方包括硬件(以NPU为主)设计制造商、大模型提供商以及终端设备(AI PC/手机)厂商,其中终端设备厂商作为唯一直接面向C端用户的角色,可能会成为这一服务模式下的流量入口。

三、AI PC/手机产业链重点公司分析

联想集团:率先推出首款AI PC概念机,预计将于2024年下半年推出

2023年10月,联想集团在第九届联想创新科技大会上展示了其人工智能个人电脑(AI PC)产品,该产品预计将于2024年下半年推出。据联想官方,其AI PC能够创建个性化的本地知识库,并通过模型压缩技术运行个人大模型,实现用户与人工智能的自然交互。

联想集团:发布AI Phone和功能性产品AI Twin,后者同时赋能个人与企业用户

就个人用户而言,AI Twin被定义为用户在数字世界的延伸,其本质上是基于本地知识库生成的属于个人的专有大模型,其能够在最大范围内了解用户的思维方式并给出解决方案。由于AI Twin只会被存储在本地化的设备或家庭服务器上,个人数据不会被共享或上传至公有云平台,因此用户的个人隐私和数据安全能够得到有效保护;企业级AI Twin涵盖一系列企业级人工智能应用,其能够打通企业内部各类智能设备、边缘和私有云,联动各种企业级软件,综合和分析各类信息并给出最优建议。例如,企业级AI Twin可以综合考虑企业的差旅政策、审批流程与员工的个人信息和偏好,为用户指定一个合理的计划。

小米:计划在终端接入轻量化本地大模型,与WPS AI达成深度合作

2023年4月,小米组建了AI大模型团队,在手机端测试了13亿参数的模型,同时小米语音助手“小爱同学”开始大模型版本内测,成为小米大模型的靠前个应用。 2023年8月,小米最新的一个13亿参数的大模型已经成功在手机本地跑通,部分场景可以媲美60亿参数模型在云端运行的结果;此外,小爱同学月活已超1.1亿,并升级AI大模型能力,开启邀请测试。 2023年10月,WPS AI在小米14系列手机新品发布会上亮相,小米14系列手机用户可通过小米社区下载搭载WPS AI 功能的专属版WPS。在小米14系列手机上,WPSAI支持输入主题一键生成PPT演示文稿,并且可以提供进一步细化调节的功能。 2023年10月,小米14系列*发骁龙8 Gen3。

Humane:推出专为与大语言模型交互而生的新式可穿戴设备AI Pin

2023年11月9日,正式推出AI Pin,后者是由提供技术支持的可穿戴设备,专为与大语言模型交互而设计。该设备允许用户通过说话来拨打电话、发送短信和搜索信息,还拥有激光显示屏,能够直接将手掌变成一个迷你屏幕,起售价$699。

报告节选:

(本文仅供参考,不代表我们的任何投资建议。如需使用相关信息,请参阅报告原文。)

精选报告来源:【未来智库】。